Was ist ein neuronales Netzwerk?

Ein neuronales Netzwerk ist ein Modell, das von der Funktionsweise des menschlichen Gehirns inspiriert wurde und zur Lösung komplexer Probleme eingesetzt wird. Es besteht aus einer Reihe von miteinander verbundenen Neuronen, die Informationen durch elektrische Signale weiterleiten.

Das Konzept eines neuronalen Netzwerks wurde erstmals in den 1940er Jahren vorgestellt, aber erst in den letzten Jahrzehnten hat es aufgrund der Fortschritte im Bereich der Computerleistung und des maschinellen Lernens an Bedeutung gewonnen. Heute werden neuronale Netze in vielen Anwendungen eingesetzt, wie z.B. Bild- und Spracherkennung, Textübersetzung, autonome Fahrzeuge und vieles mehr.

Wie funktionieren neuronale Netzwerke?

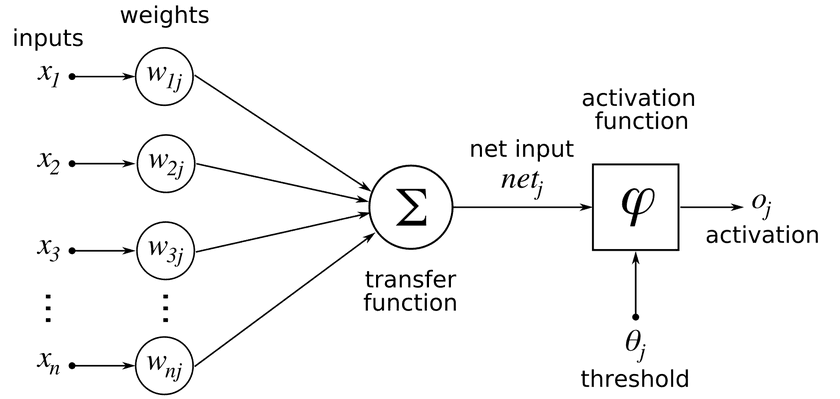

Neuronale Netzwerke bestehen aus Schichten von Neuronen, die miteinander verbunden sind. Jedes Neuron erhält Eingabedaten von anderen Neuronen oder direkt vom Benutzer und wendet eine mathematische Funktion darauf an. Die Ausgabe des Neurons wird dann an andere Neuronen weitergegeben.

Durch wiederholtes Anwenden dieser Prozesse lernt das neuronale Netzwerk Muster in den Daten zu erkennen und kann diese Muster verwenden, um Vorhersagen oder Entscheidungen zu treffen. Das Training eines neuronalen Netzwerks erfolgt durch die Anpassung der Verbindungsstärken zwischen den Neuronen basierend auf einer Zielgröße oder einem Fehlermaß.

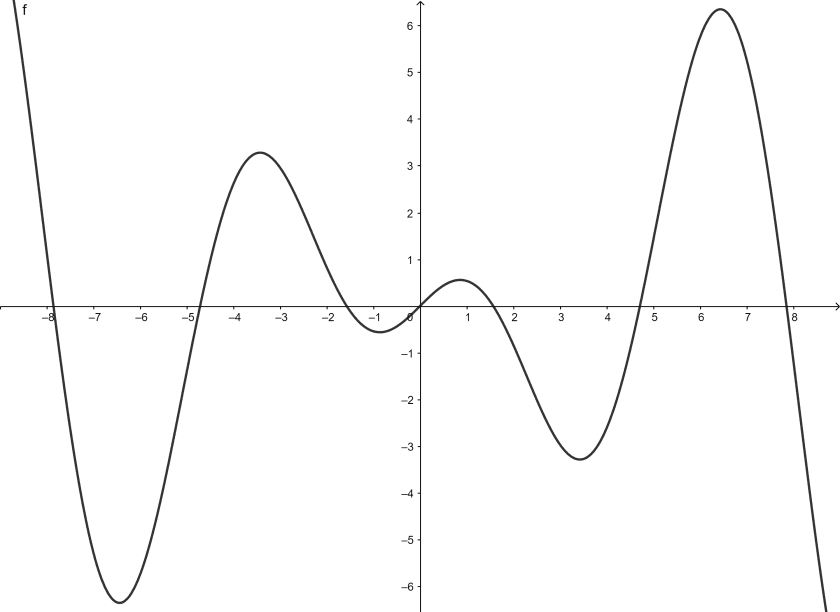

Welche Arten von Aktivierungsfunktionen werden in neuronalen Netzwerken verwendet?

Aktivierungsfunktionen sind mathematische Funktionen, die auf die Ausgabe eines Neurons angewendet werden, um sie zu normalisieren oder nichtlineare Eigenschaften hinzuzufügen. Es gibt verschiedene Arten von Aktivierungsfunktionen, die in neuronalen Netzwerken verwendet werden:

- Sigmoid: Eine S-förmige Funktion, die Werte zwischen 0 und 1 zurückgibt.

- Tanh: Eine hyperbolische Tangensfunktion, die Werte zwischen -1 und 1 zurückgibt.

- ReLU (Rectified Linear Unit): Eine lineare Funktion, die Werte größer als Null zurückgibt.

- Softmax: Eine Funktion, die eine Wahrscheinlichkeitsverteilung über mehrere Klassen berechnet.

Jede dieser Aktivierungsfunktionen hat ihre eigenen Vor- und Nachteile und kann für verschiedene Probleme besser geeignet sein. Die Wahl der richtigen Aktivierungsfunktion ist entscheidend für den Erfolg des neuronalen Netzwerks.

Wie funktionieren neuronale Netzwerke?

Neuronale Netzwerke sind Computermodelle, die auf der Funktionsweise des menschlichen Gehirns basieren. Sie bestehen aus vielen miteinander verbundenen Neuronen, die Informationen verarbeiten und weitergeben. Die Eingabe von Daten in das Netzwerk löst eine Kaskade von Aktivierungen aus, die durch Gewichtungen und Verbindungsstärken gesteuert werden. Das Ergebnis wird dann als Ausgabe des Netzwerks berechnet.

Das Training eines neuronalen Netzwerks erfolgt durch Anpassung der Gewichte und Verbindungen zwischen den Neuronen. Hierbei werden Algorithmen wie das Backpropagation-Verfahren eingesetzt, um Fehler zu minimieren und die Genauigkeit des Modells zu verbessern.

Arten von neuronalen Netzwerken

Es gibt verschiedene Arten von neuronalen Netzwerken, darunter:

- Einfache Perzeptron-Netzwerke

- Mehrschichtige Perzeptron-Netzwerke

- Faltungsnetzwerke

- Rekurrente neuronale Netzwerke

- LSTM-Netzwerke (Long Short-Term Memory)

Anwendungen von neuronalen Netzwerken

Neuronale Netzwerke finden Anwendung in verschiedenen Bereichen wie Bilderkennung, Spracherkennung, autonomen Fahrzeugen oder Finanzprognosen. Sie können auch für die Erstellung künstlicher Intelligenz und maschinellen Lernens eingesetzt werden.

Was ist eine Aktivierungsfunktion in einem neuronalen Netzwerk?

Definition

Eine Aktivierungsfunktion ist eine mathematische Funktion, die auf den Output eines Neurons im neuronalen Netzwerk angewendet wird. Sie bestimmt, ob das Neuron aktiviert oder deaktiviert wird und gibt den Output an die nächste Schicht des Netzes weiter.

Aufgabe

Die Aktivierungsfunktion spielt eine wichtige Rolle bei der Berechnung von Vorhersagen durch ein neuronales Netzwerk. Sie ermöglicht es dem Netzwerk, komplexe Muster in Daten zu erkennen und Entscheidungen zu treffen.

Beispiel

Stellen wir uns vor, wir wollen ein neuronales Netzwerk trainieren, um Bilder von Hunden und Katzen zu erkennen. Jedes Neuron im Netzwerk erhält Informationen über bestimmte Merkmale des Bildes, wie z.B. Farbe oder Form. Die Aktivierungsfunktion entscheidet dann, ob das Neuron aktiviert wird und somit zur Erkennung des Tieres beiträgt oder nicht.

Warum sind Aktivierungsfunktionen wichtig in neuronalen Netzwerken?

Komplexität

Aktivierungsfunktionen ermöglichen es neuronalen Netzen, komplexe Muster in Daten zu erkennen und Entscheidungen zu treffen. Ohne sie wäre es sehr schwierig für ein neuronales Netzwerk, Vorhersagen auf der Grundlage von Daten zu treffen.

Nichtlinearität

Ein weiterer wichtiger Aspekt von Aktivierungsfunktionen ist ihre Nichtlinearität. Ohne diese Eigenschaft könnte ein neuronales Netzwerk nur lineare Beziehungen zwischen Eingabe und Ausgabe modellieren, was die Fähigkeit des Netzes, komplexe Muster zu erkennen, stark einschränken würde.

Flexibilität

Durch die Verwendung verschiedener Aktivierungsfunktionen in verschiedenen Schichten eines neuronalen Netzwerks kann das Netzwerk flexibler gestaltet werden und besser auf verschiedene Arten von Daten und Problemen angepasst werden.

Welche Arten von Aktivierungsfunktionen werden in neuronalen Netzwerken verwendet?

Sigmoid-Funktion

Die Sigmoid-Funktion ist eine der ältesten Aktivierungsfunktionen und wird immer noch häufig verwendet. Sie hat den Vorteil, dass sie den Output auf einen Wert zwischen 0 und 1 begrenzt, was bei der Klassifizierung von Daten hilfreich sein kann.

Vorteile:

– Begrenzung des Outputs auf einen Wert zwischen 0 und 1

– Glatte Ableitung

Nachteile:

– Anfällig für das Problem des Verschwindens der Gradienten

– Langsamer Lernprozess

ReLU-Funktion

Die ReLU-Funktion (Rectified Linear Unit) ist eine der am häufigsten verwendeten Aktivierungsfunktionen. Sie ist einfach zu berechnen und hat sich als sehr effektiv erwiesen.

Vorteile:

– Einfach zu berechnen

– Schneller Lernprozess

Nachteile:

– Kann zu “totes Neuronen”-Problem führen

– Nicht differenzierbar bei x=0

Tanh-Funktion

Die Tanh-Funktion ist ähnlich wie die Sigmoid-Funktion, aber sie begrenzt den Output auf einen Wert zwischen -1 und 1.

Vorteile:

– Begrenzung des Outputs auf einen Wert zwischen -1 und 1

– Glatte Ableitung

Nachteile:

– Anfällig für das Problem des Verschwindens der Gradienten

– Langsamer Lernprozess

Wie funktioniert die Sigmoid-Aktivierungsfunktion in einem neuronalen Netzwerk?

Die Sigmoid-Aktivierungsfunktion wird auf den Output eines Neurons im neuronalen Netzwerk angewendet. Sie hat die Form einer S-Kurve und begrenzt den Output auf einen Wert zwischen 0 und 1.

Wenn der Input des Neurons groß genug ist, wird der Output nahe an 1 liegen, was bedeutet, dass das Neuron aktiviert wird. Wenn der Input klein genug ist, wird der Output nahe an 0 liegen, was bedeutet, dass das Neuron deaktiviert wird.

Die Ableitung der Sigmoid-Funktion hat auch eine interessante Eigenschaft: Sie erreicht ihr Maximum bei x=0. Das bedeutet, dass die Ableitung maximal ist, wenn das Neuron halb aktiviert ist. Dies kann bei der Berechnung von Gradienten im Backpropagation-Algorithmus hilfreich sein.

Wie funktioniert die ReLU-Aktivierungsfunktion in einem neuronalen Netzwerk?

Die ReLU-Aktivierungsfunktion wird auf den Output eines Neurons im neuronalen Netzwerk angewendet. Sie hat die Form einer geraden Linie und gibt den Input einfach weiter, wenn er positiv ist. Wenn der Input negativ ist, wird der Output auf 0 gesetzt.

Dies führt dazu, dass viele Neuronen im Netzwerk deaktiviert werden, was zu einem spärlichen Aktivierungsmuster führt. Dies kann bei der Reduzierung von Overfitting hilfreich sein.

Die Ableitung der ReLU-Funktion ist einfach: Sie ist 1 für positive Inputs und 0 für negative Inputs.

Was ist der Zweck der Verwendung mehrerer Aktivierungsfunktionen in einem neuronalen Netzwerk?

Die Verwendung mehrerer Aktivierungsfunktionen in einem neuronalen Netzwerk ermöglicht es dem Netzwerk, komplexe Muster in Daten zu erkennen und Entscheidungen zu treffen. Jede Schicht des Netzes kann verschiedene Merkmale des Inputs extrahieren und durch die Verwendung verschiedener Aktivierungsfunktionen können diese Merkmale unterschiedlich gewichtet werden.

Ein weiterer Vorteil der Verwendung mehrerer Aktivierungsfunktionen besteht darin, dass das Netzwerk flexibler gestaltet werden kann und besser auf verschiedene Arten von Daten und Problemen angepasst werden kann.

Wie wählt man die richtige Aktivierungsfunktion für eine bestimmte Aufgabe oder Problem aus?

Die Wahl der richtigen Aktivierungsfunktion hängt von verschiedenen Faktoren ab, wie z.B. dem Typ des Problems, den Eigenschaften der Daten und dem Design des neuronalen Netzes.

Einige allgemeine Empfehlungen sind:

– Für binäre Klassifizierungsprobleme kann die Sigmoid-Funktion eine gute Wahl sein.

– Für Multiklassen-Klassifizierungsprobleme ist die Softmax-Funktion eine gute Wahl.

– Die ReLU-Funktion hat sich als sehr effektiv bei der Verarbeitung von Bildern erwiesen.

– Wenn das Problem eine Ausgabe zwischen -1 und 1 erfordert, kann die Tanh-Funktion eine gute Wahl sein.

Es ist auch wichtig zu beachten, dass es keine “perfekte” Aktivierungsfunktion gibt und dass es oft notwendig ist, verschiedene Funktionen auszuprobieren und zu vergleichen, um die beste Wahl zu treffen.

Kann man ein neuronales Netzwerk ohne Aktivierungsfunktion trainieren?

Nein, ein neuronales Netzwerk ohne Aktivierungsfunktion wäre im Wesentlichen nur eine lineare Regression. Ohne Nichtlinearität wäre es sehr schwierig für das Netzwerk, komplexe Muster in Daten zu erkennen und Entscheidungen zu treffen.

Müssen alle Schichten eines neuronalen Netzwerks eine Aktivierungsfunktion haben?

Nein, nicht alle Schichten eines neuronalen Netzwerks müssen eine Aktivierungsfunktion haben. In einigen Fällen kann es sinnvoll sein, keine Aktivierungsfunktion in bestimmten Schichten des Netzes zu verwenden.

Ein Beispiel dafür wäre ein Autoencoder-Netzwerk, bei dem das Ziel darin besteht, den Input so genau wie möglich wiederherzustellen. In diesem Fall würde man keine Aktivierungsfunktion in der Ausgabeschicht verwenden.

Kann man verschiedene Aktivierungsfunktionen für verschiedene Schichten eines neuronalen Netzwerks verwenden?

Ja, es ist möglich und oft sinnvoll, verschiedene Aktivierungsfunktionen für verschiedene Schichten eines neuronalen Netzwerks zu verwenden. Dies ermöglicht es dem Netzwerk, flexibler zu sein und besser auf verschiedene Arten von Daten und Problemen angepasst zu werden.

Ein Beispiel dafür wäre ein Convolutional Neural Network (CNN), bei dem die ReLU-Funktion häufig in den Convolutional-Schichten verwendet wird und die Softmax-Funktion in der Ausgabeschicht zur Klassifizierung.

Gibt es Einschränkungen oder Nachteile bei der Verwendung bestimmter Arten von Aktivierungsfunktionen in einem neuronalen Netzwerk?

Ja, jede Art von Aktivierungsfunktion hat ihre eigenen Einschränkungen und Nachteile. Einige Beispiele sind:

– Die Sigmoid-Funktion ist anfällig für das Problem des Verschwindens der Gradienten.

– Die ReLU-Funktion kann zu “totes Neuronen”-Problem führen.

– Die Tanh-Funktion ist anfällig für das Problem des Verschwindens der Gradienten und hat einen langsameren Lernprozess als die ReLU-Funktion.

Es ist wichtig, die Vor- und Nachteile jeder Aktivierungsfunktion abzuwägen und die beste Wahl für das spezifische Problem zu treffen.

Essen und Trinken

Frühstück

Das Frühstück ist die wichtigste Mahlzeit des Tages. In Deutschland gibt es viele verschiedene Optionen für ein leckeres Frühstück. Eine beliebte Wahl ist das deutsche Frühstück mit frischem Brot, Aufschnitt, Käse und Marmelade. Dazu gibt es meistens auch eine Tasse Kaffee oder Tee. Wenn du etwas Süßes bevorzugst, solltest du unbedingt einen Pfannkuchen oder eine Waffel probieren.

Tipp:

Wenn du ein Fan von Müsli bist, kannst du dein eigenes Müsli zusammenstellen. Gehe einfach in den Supermarkt und wähle deine Lieblingszutaten aus wie Haferflocken, Nüsse und Trockenfrüchte.

Mittagessen

Zum Mittagessen gibt es in Deutschland viele verschiedene Möglichkeiten. Eine beliebte Wahl ist die Currywurst, die mit einer würzigen Soße und Pommes serviert wird. Wenn du lieber etwas Gesundes möchtest, solltest du einen Salat bestellen oder eine Suppe probieren. Ein weiteres typisch deutsches Gericht ist Schnitzel mit Kartoffelsalat.

Tipp:

In vielen Städten gibt es auch Street Food Märkte, auf denen du verschiedene Gerichte ausprobieren kannst.

Abendessen

Das Abendessen ist in Deutschland oft eine leichtere Mahlzeit als das Mittagessen. Beliebte Optionen sind belegte Brote oder eine Suppe. In vielen Restaurants gibt es auch vegetarische und vegane Optionen. Wenn du Lust auf etwas Besonderes hast, solltest du unbedingt Raclette oder Fondue probieren.

Tipp:

In Deutschland gibt es viele traditionelle Gerichte, die du unbedingt ausprobieren solltest. Frage einfach die Einheimischen nach ihren Empfehlungen!

Essen und Trinken

Als wir uns das letzte Mal getroffen haben, haben wir über Essen und Trinken gesprochen. Ich weiß, dass du gerne isst und ich auch! In Deutschland gibt es so viele leckere Gerichte zu probieren.

Berliner Pfannkuchen

Eines meiner Lieblingsgerichte sind Berliner Pfannkuchen. Sie sind eine Art Donut mit einer süßen Füllung aus Marmelade oder Vanillecreme. Du findest sie in fast jeder Bäckerei in Deutschland. Wenn du sie noch nie probiert hast, solltest du das unbedingt tun!

Weißwurstfrühstück

Noch ein typisch deutsches Gericht ist das Weißwurstfrühstück. Es besteht aus Weißwürsten, Brezen (Laugenbrezeln) und süßem Senf. Es wird traditionell zum Frühstück gegessen und ist besonders in Bayern beliebt. Wenn du die Gelegenheit hast, es zu probieren, lass es dir nicht entgehen!

Reisen

Ich weiß, dass du gerne reist und ich auch! Deutschland hat so viele schöne Orte zu besuchen.

Schwarzwald

Eine Region, die du unbedingt besuchen solltest, ist der Schwarzwald. Er ist bekannt für seine malerischen Dörfer, dichten Wälder und atemberaubende Landschaften. Du kannst wandern gehen oder einfach nur spazieren gehen und die Schönheit der Natur genießen.

Berlin

Eine Stadt, die du nicht verpassen solltest, ist Berlin. Sie hat eine reiche Geschichte und Kultur zu bieten. Du kannst das Brandenburger Tor besichtigen, das Jüdische Museum besuchen oder einfach nur durch die Straßen schlendern und die Atmosphäre genießen.

Tipp:

- Wenn du nach Berlin reist, solltest du unbedingt den Mauerpark besuchen. Dort gibt es jeden Sonntag einen Flohmarkt und eine Karaoke-Show im Freien.

Zusammenfassend können wir sagen, dass neuronale Netze eine Aktivierungsfunktion haben, die es ihnen ermöglicht, komplexe Probleme zu lösen und Muster in Daten zu erkennen. Wenn Sie mehr über unsere AI-Dienstleistungen erfahren möchten, zögern Sie nicht, uns zu kontaktieren und besuchen Sie unsere Website. Wir helfen Ihnen gerne weiter!

Benötigen neuronale Netzwerke eine Aktivierungsfunktion?

Aktivierungsfunktionen sind ein entscheidender Bestandteil von neuronalen Netzen, da sie Nichtlinearität einführen. Dies ermöglicht es neuronalen Netzen, komplexe Darstellungen und Funktionen auf der Grundlage von Eingaben zu erstellen, die mit einem einfachen linearen Regressionsmodell nicht erreicht werden können.

Was ist die Aktivierungsfunktion in neuronalen Netzen?

Eine Aktivierungsfunktion in künstlichen neuronalen Netzen ist ein Mechanismus, der einen kleineren Wert für kleine Eingaben und einen höheren Wert für größere Eingaben produziert, die einen bestimmten Schwellenwert überschreiten. Wenn die Eingabe groß genug ist, löst die Aktivierungsfunktion eine Reaktion aus; andernfalls bleibt sie inaktiv.

Kann ein neuronales Netzwerk verschiedene Aktivierungsfunktionen haben?

Neuronale Netze verwenden verschiedene Aktivierungsfunktionen, aber nur eine begrenzte Anzahl von Funktionen wird typischerweise für versteckte und Ausgangsschichten eingesetzt. Wir werden uns die für jeden Schichttyp verwendeten Aktivierungsfunktionen einzeln ansehen.

Hat CNN eine Aktivierungsfunktion?

Ein Convolutional Neural Network (CNN) ist eine Art von fortgeschrittenem maschinellem Lernrahmen, der Bilder verarbeitet, indem er Faltungen und Pooling anwendet. Es geht dann durch eine vollständig verbundene Schicht und eine Aktivierungsfunktion, um eine Ausgabe zu produzieren.

Was passiert, wenn es keine Aktivierungsfunktion im neuronalen Netzwerk gibt?

In Deep Learning ist ein neuronales Netzwerk ohne Aktivierungsfunktion nur ein lineares Regressionsmodell, da diese Funktionen tatsächlich die nichtlinearen Berechnungen an dem Eingang eines neuronalen Netzwerks durchführen, was es ihm ermöglicht, komplexere Aufgaben zu erlernen und auszuführen. 14. April 2021

Was wird passieren, wenn es keine Aktivierungsfunktion im neuronalen Netzwerk gibt?

Wenn Sie keine Aktivierungsfunktion in einem neuronalen Netzwerk verwenden, wird es zu einem riesigen linearen Regressionsmodell als (X*W1*W2*W3) + (b1*W2*W3 + b2*W3 + b3), das vereinfacht werden kann zu (X*W) + B. Außerdem wären die versteckten Schichten nutzlos und das Modell würde keine nichtlineare Beziehung in den Daten lernen.